Ten artykuł przeczytasz w 6 minut.

Wyobraź sobie czarną skrzynkę, która ma za zadanie podejmować decyzje wpływające na Twoje finanse, zdrowie czy szanse na kredyt. Wrzucasz do niej dane na Twój temat, a po chwili otrzymujesz odpowiedź wygenerowaną nie przez specjalistę… ale przez algorytm, który nie potrafi uzasadnić swojej decyzji. W taki sposób działa wiele dużych modeli językowych – precyzyjnych i szybkich, ale nieprzejrzystych. Dlatego właśnie badacze i twórcy AI zaczęli uczyć maszyny tłumaczenia się z własnych wyborów.

Co kryją głębokie sieci?

Black-box AI to takie modele, które działają jak czarne skrzynki, czyli dają statystycznie precyzyjne wyniki, ale nie wyjaśniają, jak do nich doszły. Nie można bezkrytycznie zakładać jednak, że wynik jest precyzyjny i słuszny. To sztuczna inteligencja oparta na skomplikowanych algorytmach, których wewnętrzne działanie jest nieprzejrzyste – w szczególności głębokie sieci neuronowe. Użycie takiego modelu może być korzystne tam, gdzie liczy się wydajność. Modele o charakterze czarnych skrzynek znajdują zastosowanie m.in. na rynku nieruchomości, służąc do wyceny i prognoz, a także w finansach do opracowywania modeli ryzyka i wykrywania oszustw czy też w marketingu, oferując personalizację doświadczeń, rekomendacje produktów i obsługę klienta.

Wysoka dokładność (np. w przetwarzaniu obrazów, dużych danych), zdolność do modelowania nieliniowych zależności i skalowalność przy dużych zbiorach danych pozwalają na automatyzację lub usprawnienie zawiłych procesów – ma to jednak swoją cenę. Takie modele są trudne do zrozumienia, ich skomplikowana struktura i złożony proces decyzyjny są nieprzejrzyste, ponieważ zyskują one najwyższą dokładność kosztem transparentności. Idzie za tym szereg zagrożeń:

- ukryte uprzedzenia, które prowadzą do dyskryminacji i trudności w wykryciu takich uprzedzeń, błędów (np. przeuczenie, błędne korelacje),

- problemy z odpowiedzialnością i etyką (np. system deprecjacji nieruchomości w wybranych dzielnicach lub oferowanie nieadekwatnych porad specjalistycznych),

- comprehension debt – dług poznawczy, wynikający z braku zrozumienia decyzji skomplikowanego modelu, który narasta i utrudnia rozwój systemu AI.

Brak zrozumienia modelu może prowadzić do akumulacji błędów i trudności w jego kontroli, co skutkuje obniżonym zaufaniem do niego. Żeby zrozumieć, jak działa taki algorytm, trzeba opracować dodatkowe narzędzia post-hoc do wyjaśnień.

Rzućmy na to nieco światła

Explainable AI (XAI) – dziedzina badań obejmująca narzędzia, procesy, metody i modele, które dostarczają przejrzystych wyjaśnień, dlaczego i jak algorytm podjął akurat taką decyzję, uwzględniając zarówno jego mocne, jak i słabe strony. To systemy analizujące mechanizm działania, efektywność i przewidywalność. Stanowią odpowiedź na wady nieprzejrzystej sztucznej inteligencji, zwiększając zaufanie i odpowiedzialność, ich celem jest przekształcenie czarnych skrzynek w modele szklane, czyli interpretowalne, wyjaśnialne i transparentne oraz zgodne z regulacjami na temat etycznego użytkowania AI. Im mocniej sztuczna inteligencja wrasta w tkankę życia codziennego, wpływając na szerokie spektrum decyzji, tym bardziej wymaga przekształcenia w kierunku choćby częściowej przejrzystości. Modele interpretowalne mają niższą dokładność, ale cechują się większą przejrzystością i sprawdzalnością.

XAI obejmuje dwa kluczowe aspekty:

- Interpretowalność i transparentność – jak model jest skonstruowany i dlaczego zachowuje się tak, jak się zachowuje. Obejmuje poznanie ogólnych zależności pomiędzy wewnętrznymi cechami modelu a wynikami predykcji.

- Wyjaśnialność – analiza i wyjaśnienie, dlaczego model podjął konkretną decyzję dla pojedynczego przypadku (lokalna interpretacja).

Stosowanie XAI pozwala użytkownikom lepiej rozumieć decyzje modelu, co z kolei pozytywnie wpływa na wykrywalność błędów i uprzedzeń. Możliwość szybkiej i trafnej korekty oraz dostosowania algorytmu do zmieniających się przepisów daje użytkownikom poczucie kontroli i sprawczości, zwiększając zaufanie do narzędzia. Model transparentny i interpretowalny budzi zaufanie i zmniejsza ryzyko biznesowe – szczególnie ważne w sektorach takich jak zdrowie, finanse, fuzje i przejęcia czy decyzje strategiczne.

Zwraca się uwagę na silny związek między wyjaśnialnością a meta-reasoningiem, czyli zdolnością AI do „myślenia” o swoim własnym „myśleniu”. Takie wnioskowanie z metapoziomu to kluczowy krok w dalszym rozwoju prawdziwie zrozumiałych, „samowyjaśniających się” XAI.

Badacze z IBM zwracają uwagę na to, że XAI tłumaczy działanie już po tym, jak model coś przewidział, dlatego postulują tworzenie responsible AI – sztucznej inteligencji od początku zaplanowanej, zaprojektowanej i wdrożonej z uwzględnieniem zagadnień etycznych, społecznych i prawnych.

Przykład: e-myślenie pod mikroskopem

Anthropic opracowało „mikroskop” – nowe narzędzie do badania wewnętrznych procesów myślowych modeli językowych (np. Claude), którego celem jest zrozumienie, jak modele dochodzą do odpowiedzi („czy planują?”, „jakie strategie stosują?”), zamiast traktować je jako czarne skrzynki. Metoda została użyta m.in. do analizy poezji, planowania dłuższych odpowiedzi i detekcji halucynacji. Pozwala obserwować, które obwody przetwarzają dane koncepcje. Wśród odkryć badaczy znalazł się chociażby fakt, że Claude nie myśli w żadnym konkretnym języku.

TL;DR

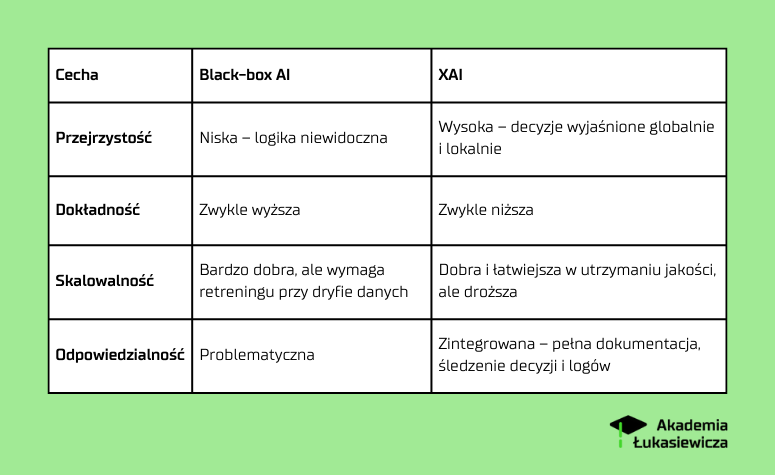

Tradycyjne modele black-box AI cechują się wysoką skutecznością, ale ich decyzje są nieprzejrzyste, co utrudnia identyfikację błędów, uprzedzeń i egzekwowanie odpowiedzialności. Explainable AI (XAI) rozwija narzędzia i metody pozwalające zrozumieć, jak i dlaczego algorytm podjął konkretną decyzję, zwiększając zaufanie użytkownika. Nowe badania pozwalają zaglądać w głąb procesów decyzyjnych modeli, otwierając drogę do bardziej zrozumiałej i etycznej sztucznej inteligencji. Poniżej znajdziesz skrócone porównanie modeli z grupy czarnych skrzynek i tych wyjaśnialnych.